Formación de la imagen y Profundidad de color

En el artículo anterior, vimos que la retina capta la luz mediante células sensibles al azul, verde y rojo. Se puede establecer una analogía bastante directa con el sensor de una cámara digital, ya que ambos cumplen la función de registrar la imagen que proyecta el objetivo en el caso de la cámara, y la córnea y el cristalino en el del ojo. En éste artículo recorremos las etapas de la captura y las propiedades de la imagen.

¿Cómo capta la luz el sensor de una cámara digital?

El sensor consiste en una grilla de componentes electrónicos, los fotodiodos o fotorreceptores, que están distribuidos en filas y columnas como un piso de mosaicos cubriendo la superficie del sensor. Al recibir luz generan una pequeña carga eléctrica proporcional a la intensidad de luz que recibieron, es decir que en el instante de la captura el procedimiento no es digital sino analógico. En la etapa siguiente la carga eléctrica almacenada por cada receptor es medida y transformada en información digital por otro dispositivo, el conversor analógico – digital, la información codificada en dígitos que corresponde a un fotodiodo es lo que denominamos píxel, a partir de esta etapa podemos hablar de imagen digital o información del archivo.

Una cámara de 24 megapíxeles tiene un sensor con veinticuatro millones de fotorreceptores, las réflex digitales de gama media suelen tener un sensor de aproximadamente 15×24 mm. En esa superficie están distribuidos los veinticuatro millones de fotodiodos del ejemplo.

Los fotorreceptores no son sensibles al color, no diferencian las longitudes de onda. Solo la luminosidad. Hay dos sistemas para producir el registro de la información del color de la escena.

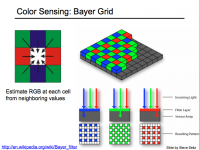

El más empleado es la matriz matriz de Bayer* un mosaico de pequeños filtros rojos, verdes y azules, se ubica un filtro encima de cada fotorreceptor, que de este modo genera la carga eléctrica correspondiente al rojo, verde o azul en ese punto, que luego se transformará en la información del pixel respectivo. (Clic para ampliar la imagen) Como nuestra retina tiene el doble de conos sensibles al verde respecto al azul y al rojo, la matriz de Bayer también tiene el doble de filtros verdes respecto a los azules y rojos, para que el registro del color se aproxime al nuestro.

Una vez que el conversor analógico digital convierte la carga eléctrica en información esta es empleada por el procesador para realizar la la interpolación de color (demosaicing), es decir el cálculo matemático que define el color de cada píxel en función de los componentes de color de los píxeles adyacentes.

El otro sistema de separación de color es el Foveon, cuyos sensores poseen tres capas de fotorreceptores superpuestas, y cada capa registra la información correspondiente al azul, verde y rojo cuyas longitudes de onda penetran el silicio de los fotorreceptores con diferente profundidad.(Clic para ampliar la imagen)

Este tipo de separación de color es semejante al que se emplea en las películas color, que poseen capas de emulsión superpuestas sensibles cromáticamente al rojo, verde y azul. Si bien es muy atractivo teóricamente en la práctica es empleado hasta ahora solo por las cámaras Sigma, con excelente rendimiento a baja sensibilidad pero con excesivo ruido en valores de ISO más altos.

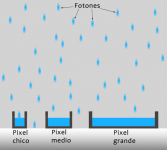

Por otra parte una variable importante en la calidad de la imagen es el tamaño del sensor. Los formatos más habituales en cámaras reflex son el APS-C y el Full Frame. Cuanto mayor es el tamaño del sensor mayor es el tamaño de cada fotodiodo, esto hace que capture mayor cantidad de fotones en cada fotorreceptor es decir, que cada pixel se forma a partir de una carga eléctrica mayor dando como resultado una imagen con menos ruido. (Clic para ampliar la imagen) El ruido electrónico es inevitable en cualquier sistema de amplificación, es probable que hayas experimentado que cuando un amplificador de sonido se encuentra a un volumen alto pero sin reproducir música se escucha un zumbido. Cuando comienza la música el zumbido persiste, pero no lo escuchamos porque la música “lo tapa”. En las fotografías digitales el ruido se percibe como una trama que no corresponde a la imagen. Cuando empleamos un ISO alto la señal captada por el sensor debe amplificarse más que a un ISO bajo, y el nivel de ruido aumenta. Los sensores pequeños capturan pocos fotones en cada fotodiodo, la señal debe amplificarse en mayor medida y el ruido es mayor. En definitiva los sensores de mayor tamaño producen imágenes con menos ruido y mayor rango dinámico.

(Clic para ampliar la imagen)

A su vez hay dos tecnologías de sensores utilizados en fotografía los, CCD y los CMOS en estos últimos el conversor analógico digital se encuentra integrado al sensor. Inicialmente los CCD lograron más alta calidad de imagen, pero en el desarrollo a través del tiempo los CMOS llegaron a una ecuación de rendimiento superior, consumen menos energía y su fabricación es más económica, actualmente el estándar en las cámaras -aún en las de mejores prestaciones- se obtiene mediante la combinación de sensor CMOS y matriz de Bayer. Los sensores CCD siguen presentando ventajas para algunas aplicaciones específicas, pero ya no en el mercado estándar de las cámaras fotográficas. Actualmente una nueva generación de sensores, los BSI-CMOS de costo inicialmente muy elevado se va incorporando a los nuevos modelos.

*(por su inventor llamado Bryce Bayer, no por el laboratorio)

Profundidad de color:

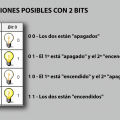

¿Cómo se guarda la información de color en un archivo? Primero debemos conocer un concepto básico de informática: el bit, la unidad mínima de información que puede almacenarse y que se puede comparar al estado de encendido o apagado de una lámpara, a la que asignamos un valor cuando está apagada y otro cuando está encendida. Por ejemplo: sí o no, rojo o verde, verdadero o falso, blanco o negro.

Si dispusiéramos de una cámara capaz de guardar solo un bit por cada pixel podríamos asignarle por ejemplo blanco y negro como valores. En este caso la imagen más allá de que resultara interesante o no, sería muy pobre como descripción de la imagen real de la escena que veríamos con nuestros ojos. Si la cámara pudiese guardar la información correspondiente a dos bits, podríamos guardar la información correspondiente a cuatro posibilidades distintas, por ejemplo blanco, gris claro, gris oscuro y negro, esta imagen resultaría un poco más descriptiva que la anterior. Con tres bits podríamos guardar ocho valores, por ejemplo, blanco, seis grises y negro, y esta imagen tendría mayor riqueza que las anteriores.

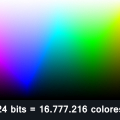

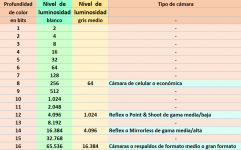

Sabemos que nuestra visión puede diferenciar aproximadamente 16,8 millones de colores, dado que nuestros ojos pueden distinguir 255 valores de luminosidad para cada color primario, rojo, verde y azul; así es que para conseguir que en un archivo quede registrada la información de color que somos capaces de ver, hace falta que este pueda almacenar 255 posibilidades diferentes, eso se consigue con un archivo de 8 bits para el rojo, otro tanto para el verde y otros 8 bits para el azul, en total un archivo de 24 bits, esta es la profundidad de color mínima necesaria para reproducir una imagen en “color real”, lo que se estima somos capaces de ver. Sin embargo aún cámaras básicas tienen una profundidad de color de 12 bits por canal, esto es 4096 niveles de luminosidad para cada color primario, mucho más de los que somos capaces de ver los seres humanos. Las cámaras de gama media (Nikon D7000 , Canon D70 en adelante) disponen de 14 bits (16.384 niveles por canal) y las de máximo rendimiento 16 bits (65.536 niveles por canal) ¿Pero cuál es la utilidad de guardar tanta información?La respuesta debe contemplar dos aspectos, en primer lugar, cada vez que editamos una foto digital, al hacer un reencuadre, aclarar u oscurecer una parte, cambiarla de tamaño, enfocarla, etc. perdemos información, si lo hacemos a partir de un archivo de 8 bits la pérdida se notará en el resultado final, según los cambios que hayamos realizado y el tipo de imagen esa degradación de calidad resultará más o menos visible.

A su vez el registro de la información en un archivo de imagen es lineal, esto quiere decir que un archivo de 12 bits alcanza los 4096 niveles de luminosidad en las altas luces, muy próximas al blanco. Un punto de exposición por debajo el registro será de 2048 niveles, un punto más bajo 1024, luego 512, 256, 128, 64, 32, 16, 8, 4, 2 y O al llegar al negro la ausencia de información. En este caso el registro de valores cercanos al negro, entre 0 y 32 niveles, difícilmente producirá información que pueda visualizarse e imprimirse, el rango aprovechable seguramente se encontrará entre los 4096 y los 64 niveles y esto determinará un rango dinámico aproximado de seis puntos de exposición

Considerando que el gris medio se encuentra dos puntos de exposición por debajo del blanco en un archivo de 8 bits tendremos la información correspondiente a 256 niveles en el blanco y 64 en el gris medio, en uno de 12 bits 4096 (blanco) y 1048 (gris medio), en 14 bits 16.384 y 4.096 respectivamente, y en uno de 16 bits, 65.536 en el blanco y 16.384 en el gris medio. Como se ve la diferencia en la cantidad de información capta para componer la imagen es enorme.(Clic para ampliar la imagen) Este punto es central ya que de los tonos medios a los más bajos es donde la exigencia de calidad será más evidente. La cantidad de niveles de luminosidad que es posible guardar en cada pixel también es determinante del rango dinámico de una imagen, que será mayor cuanto más amplia sea la profundidad de color. El ruido sobre todo en la zona de sombras también será menor. En definitiva una imagen con mayor profundidad de color dispone de más información que se traduce en mayor calidad. Por supuesto que no es la única variable que determina la calidad de la imagen, pero si uno de los factores más relevantes.

Mi agradecimiento a mi hijo Teo Fumagalli por programar una aplicación para graduar la profundidad de color de las fotografías bit por bit.

®Carlos Fumagalli.